Topic

Small-Language-Model Distillation

JackerLab

2025. 6. 17. 20:30

728x90

반응형

개요

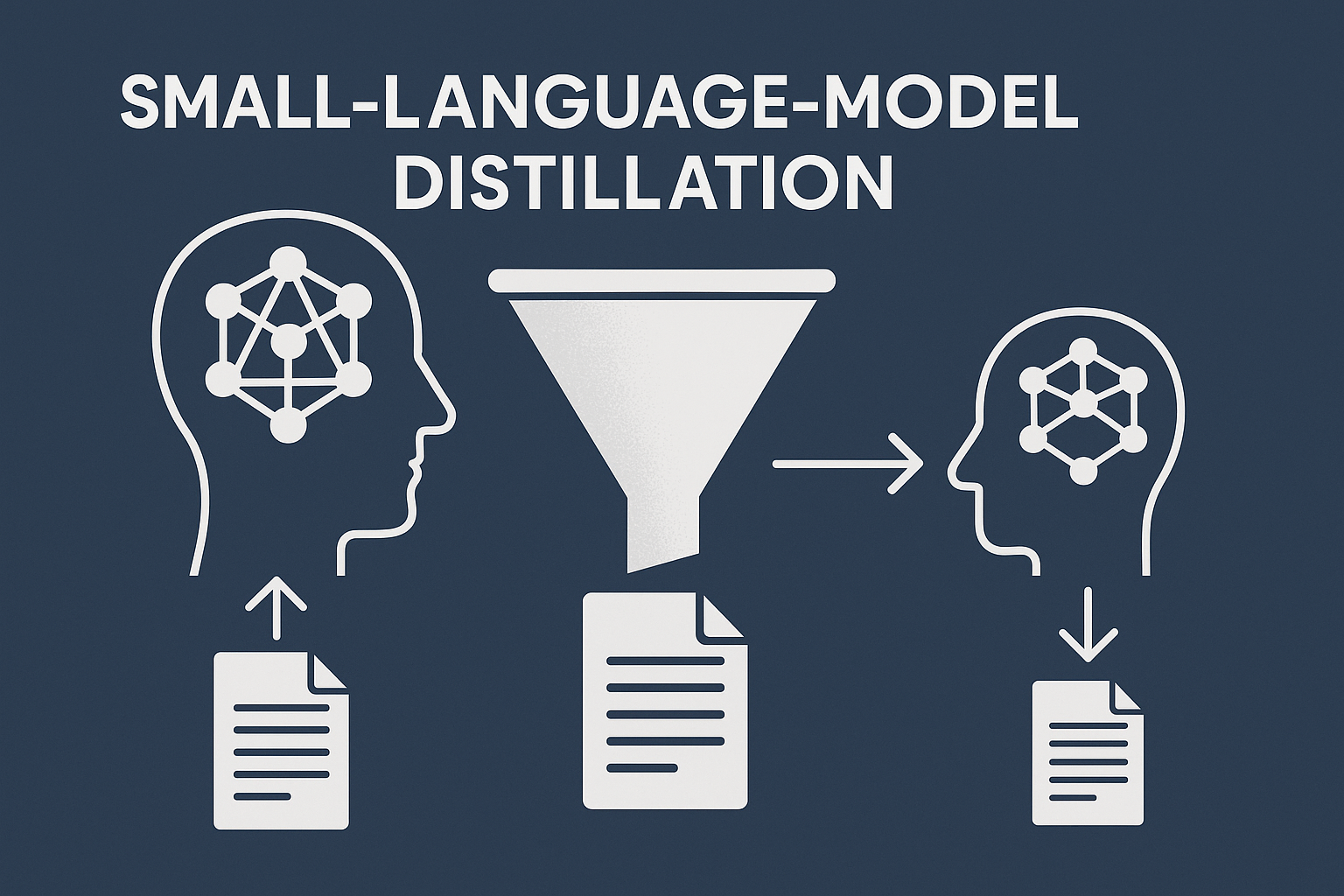

최근 대형 언어 모델(Large Language Model, LLM)의 활용이 증가함에 따라, 제한된 자원 환경에서도 효과적인 AI 시스템을 구현하기 위한 기술로 Small-Language-Model Distillation(소형 언어 모델 지식 증류)이 주목받고 있습니다. 본 포스트에서는 LLM으로부터 작은 모델로 지식을 전이하는 증류(distillation) 기술의 개념, 필요성, 적용 방식 및 실제 사례를 중심으로 상세히 살펴봅니다.

1. 개념 및 정의

Small-Language-Model Distillation은 고성능의 대형 언어 모델(teacher model)로부터 작은 언어 모델(student model)로 지식을 압축하여 전이하는 기술입니다. 이 방법은 성능 저하를 최소화하면서도 경량화된 모델을 확보하는 것을 목표로 하며, 특히 모바일 디바이스, 엣지 컴퓨팅 환경, 비용 민감형 AI 시스템에서 유용합니다.

2. 특징

| 구분 | Small-Language-Model Distillation | 일반 모델 학습 |

| 목적 | 성능 유지 + 모델 크기 축소 | 정확도 향상 중심 |

| 대상 | LLM → 소형 모델 | 학습 데이터 기반 학습 |

| 장점 | 연산 비용 절감, 배포 용이성 향상 | 고성능 모델 구축 |

- Knowledge Transfer: 대형 모델의 출력 분포(logits), attention weights 등을 활용한 다층적 지식 전달

- Training Efficiency: 소형 모델이 직접 학습할 때보다 훨씬 빠르게 수렴

- 정밀도 유지: 고성능 모델의 추론 능력 일부를 유지한 상태로 작동

3. 구성 요소

| 구성 요소 | 설명 | 예시 |

| Teacher Model | 지식을 제공하는 LLM | GPT-4, LLaMA 2, PaLM 등 |

| Student Model | 지식을 전이받는 소형 모델 | DistilBERT, TinyLLaMA 등 |

| Loss Function | Knowledge Distillation Loss + CE Loss | KL Divergence, MSE, CrossEntropy 등 |

| 데이터셋 | 동일한 입력으로 teacher와 student를 동시에 학습 | OpenWebText, C4, Wikipedia 등 |

- 증류 손실 함수(KD Loss)는 soft target을 고려하여 모델 간 출력 차이를 최소화

- 일부 설정에서는 intermediate layer나 attention map도 증류에 사용

4. 기술 요소

| 기술 요소 | 설명 | 적용 기술 |

| Soft Labeling | LLM의 soft output(logits) 사용 | Temperature scaling 기법 활용 |

| Intermediate Feature Matching | 중간 layer feature를 맞추는 방식 | FitNets, Attention Transfer 등 |

| Multi-task Learning | 기본 task 학습과 병행하여 KD 적용 | QA + Classification 동시 학습 |

- Temperature 조절을 통해 soft label의 정보 풍부도를 증가시켜 증류 효과 극대화

- Transformer 구조의 attention 증류 기법도 최근 각광받음 (TinyBERT 등에서 사용)

5. 장점 및 이점

| 장점 | 설명 | 기대 효과 |

| 모델 경량화 | 파라미터 수 감소 | 디바이스 배포 적합 |

| 추론 속도 개선 | 연산량 감소 | 실시간 처리 가능 |

| 비용 절감 | GPU 자원 소모 감소 | 서버 운영비 절감 |

| 유연성 향상 | 다양한 환경에 적용 가능 | 엣지, 모바일 환경 지원 |

- 대형 모델을 사용할 수 없는 환경에서도 유사한 성능 달성 가능

- 추론 시간, 메모리 사용량 등을 고려한 최적화에 유리

6. 주요 활용 사례 및 고려사항

| 사례 | 설명 | 적용 포인트 |

| Chatbot | 모바일 고객센터 AI | 배터리 효율, 응답 속도 |

| 음성비서 | IoT 기반 음성 인터페이스 | 실시간 음성 처리 |

| 번역기 | 스마트폰 내장 번역 앱 | 오프라인 동작 |

| 검색엔진 | 경량화된 쿼리 이해 모델 | Latency 최소화 |

고려사항:

- Teacher 모델의 라이선스 문제 및 학습 데이터 정합성

- 증류 시 데이터 다양성 부족 시 성능 저하 우려

- Student 모델에 과도한 압축 시 성능 열화 가능성

7. 결론

Small-Language-Model Distillation은 대형 모델의 능력을 유지하면서도 경량화된 모델을 통해 실제 환경에서의 효율적인 AI 구현을 가능하게 합니다. 특히 실시간성과 자원 제약이 중요한 분야에서 폭넓은 활용이 기대되며, 앞으로도 다양한 구조 및 목적에 맞춘 증류 기법이 진화해 나갈 것입니다.

728x90

반응형