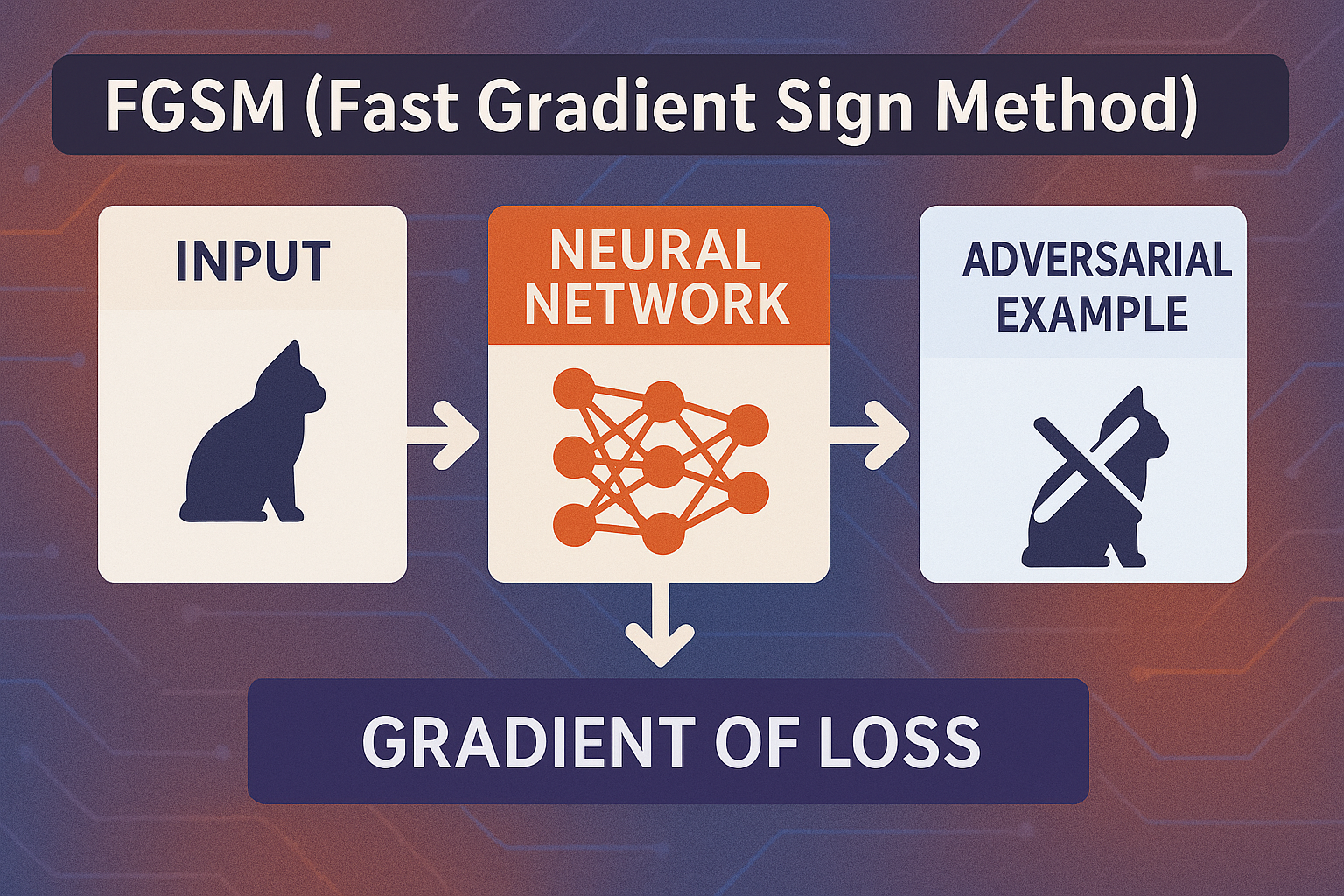

개요PGD(Projected Gradient Descent)는 딥러닝 모델에 대한 적대적 공격 기법 중 가장 강력하고 일반적인 방법으로, 반복적인 그래디언트 업데이트와 투영 과정을 통해 최적의 적대적 예제를 생성합니다. 본 글에서는 PGD의 이론적 원리와 수식, 주요 특징, 구현 방법, 실제 적용 사례 및 방어 전략 등을 포괄적으로 설명합니다.1. 개념 및 정의PGD는 입력 공간에서 손실 함수를 최대화하는 방향으로 여러 번 그래디언트를 계산하고, 그 결과를 원래 입력 범위로 투영하여 적대적 예제를 생성하는 공격 방식입니다. FGSM의 확장된 반복형으로도 간주됩니다.목적: 모델의 예측 취약성을 극대화하기 위한 고강도 테스트필요성: 실제 환경에서 AI 시스템의 보안성과 견고성 검증기반 원리: 경사하강법을 반..