728x90

반응형

개요

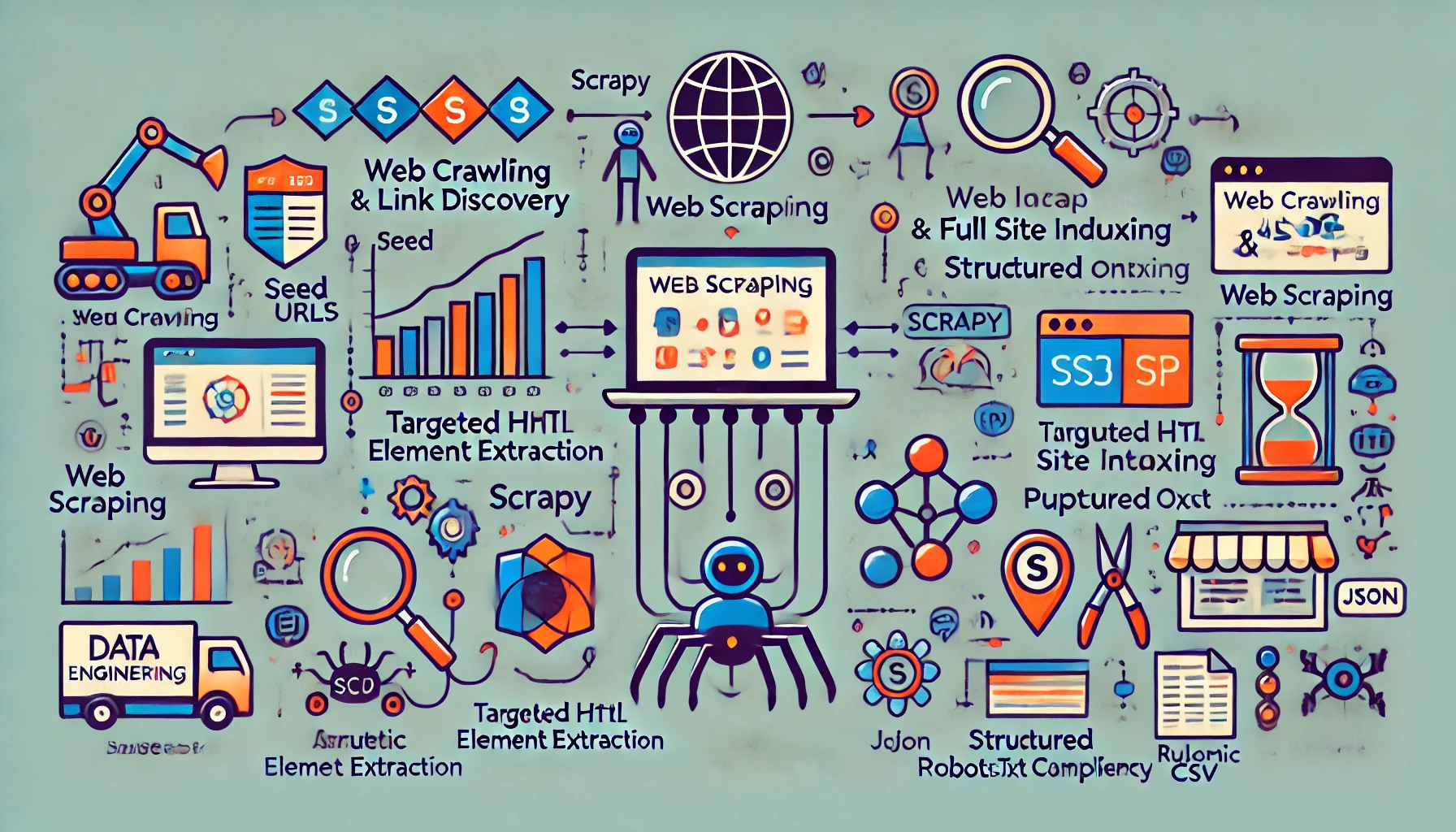

웹은 가장 방대한 데이터 원천 중 하나이며, 이를 자동화된 방식으로 수집하는 기법이 바로 **웹 크롤링(Web Crawling)**과 **웹 스크래핑(Web Scraping)**입니다. 둘은 종종 혼용되지만 목적과 처리 범위, 기술 방식에서 뚜렷한 차이가 있습니다. 본 글에서는 웹 크롤링과 스크래핑의 정의, 차이점, 기술 도구, 법적 이슈, 실무 적용 전략 등을 비교·정리합니다.

1. 정의 및 차이점

| 구분 | 웹 크롤링 (Web Crawling) | 웹 스크래핑 (Web Scraping) |

| 목적 | 전체 웹사이트 구조 탐색 및 URL 수집 | 특정 페이지의 데이터 추출 |

| 작동 방식 | 링크를 따라가며 페이지를 순차적으로 수집 | 정해진 요소에서 정보만 추출 |

| 출력 대상 | HTML 전체, URL 목록 | 구조화된 데이터 (JSON, CSV 등) |

| 활용 분야 | 검색 엔진, 데이터 수집 인프라 | 뉴스/상품 정보 수집, 모니터링 |

크롤링은 '어디에 무엇이 있는가'를 찾고, 스크래핑은 '그 중 무엇을 수집할 것인가'에 집중합니다.

2. 주요 기술 및 도구

| 목적 | 도구 | 설명 |

| 크롤링 | Scrapy (Python), Heritrix (Java) | 다수 URL 탐색, 대용량 수집용 프레임워크 |

| 스크래핑 | BeautifulSoup, Selenium, Puppeteer | 특정 HTML 요소 추출, 자바스크립트 처리 가능 |

| API 접근 대체 | Requests, aiohttp | REST API 또는 Ajax 대응용 요청 도구 |

| 구조화 | Pandas, JSON, CSV Writer | 수집 결과 데이터 변환 및 저장 |

| 분산 처리 | Apache Nutch, scrapy-cluster | 대규모 병렬 크롤링 시스템 구축 |

Selenium은 JS 기반 렌더링까지 지원하며, 동적 웹사이트 대응에 강력합니다.

3. 웹 크롤링 아키텍처 흐름

- Seed URL 설정

- URL 큐에 등록 (Queue)

- 페이지 요청 및 수신 (HTTP GET)

- 링크 추출 → 새로운 URL 탐색

- robots.txt 확인 및 우회 처리

- 콘텐츠 저장 (HTML or 원본 데이터)

- 중복 제거, 스케줄링, 재방문 처리

크롤러는 ‘정보 구조 탐색’에 강하며, 스크래핑은 ‘정보 정제·수집’에 특화됩니다.

4. 법적 이슈 및 주의사항

| 항목 | 설명 |

| robots.txt | 사이트가 허용하는 크롤링 범위 명시 (비강제) |

| 서비스 약관(TOS) | 일부 웹사이트는 자동 수집 자체를 금지할 수 있음 |

| 저작권 | 수집된 콘텐츠의 활용 범위(비상업/상업)에 따라 법적 문제 가능 |

| 개인정보 | 이름, 위치 등 민감한 정보 수집 시 법적 제재 대상 가능성 |

| 속도 제한 | 과도한 요청은 IP 차단 및 법적 고지 대상이 될 수 있음 |

정기적 요청 간격 유지, User-Agent 설정, robots.txt 준수는 기본 예의입니다.

5. 실무 활용 사례

| 산업 | 활용 목적 | 예시 |

| 이커머스 | 경쟁사 가격/리뷰 수집 | 크롤링+스크래핑 병행, 자동 비교 툴 개발 |

| 금융 | 뉴스 기사 기반 감성 분석 | 크롤링 후 텍스트 분석으로 리스크 지표 생성 |

| 부동산 | 지역별 시세 정보 수집 | 스케줄러 기반 자동화, 지도 API 연계 |

| 학술/논문 | 논문 메타데이터 수집 | DOI 기반 크롤링 후 BibTex 추출 |

| SNS | 사용자 반응 모니터링 | Webhook 또는 API 대체 + 스크래핑 병행 |

크롤링 + 스크래핑은 데이터 수집 인프라 구축의 양 날개입니다.

6. 결론

웹 크롤링과 스크래핑은 현대의 데이터 수집에서 가장 유연하고 강력한 도구입니다. 특히 정형화된 API가 없는 환경에서도 활용할 수 있으며, 실시간 시장 정보, 사용자 피드백, 콘텐츠 메타 정보 등 다양한 비정형 데이터를 자동으로 확보할 수 있습니다. 다만, 법적·윤리적 책임을 인식하고, 적절한 수집 범위 내에서 활용하는 것이 중요합니다.

728x90

반응형

'Topic' 카테고리의 다른 글

| 데이터 공유 기술(Data Sharing Technologies) (0) | 2025.04.21 |

|---|---|

| 데이터 전처리 기술(Data Preprocessing Techniques) (0) | 2025.04.21 |

| 데이터 수집 기술(Data Ingestion Technologies) (1) | 2025.04.21 |

| 빅데이터 표준(Big Data Standards) (1) | 2025.04.21 |

| 패스트데이터(Fast Data) (0) | 2025.04.21 |