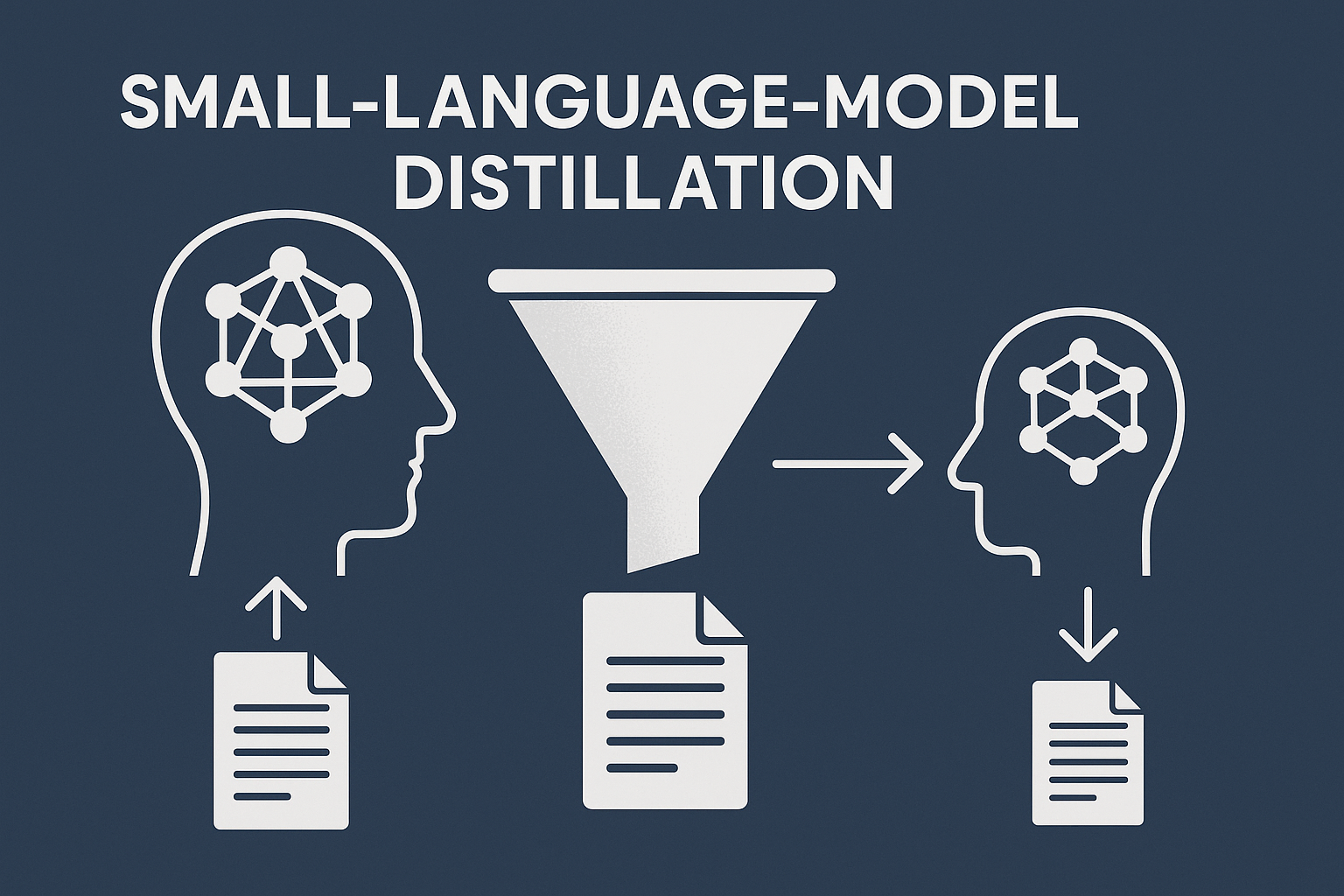

개요최근 대형 언어 모델(Large Language Model, LLM)의 활용이 증가함에 따라, 제한된 자원 환경에서도 효과적인 AI 시스템을 구현하기 위한 기술로 Small-Language-Model Distillation(소형 언어 모델 지식 증류)이 주목받고 있습니다. 본 포스트에서는 LLM으로부터 작은 모델로 지식을 전이하는 증류(distillation) 기술의 개념, 필요성, 적용 방식 및 실제 사례를 중심으로 상세히 살펴봅니다.1. 개념 및 정의Small-Language-Model Distillation은 고성능의 대형 언어 모델(teacher model)로부터 작은 언어 모델(student model)로 지식을 압축하여 전이하는 기술입니다. 이 방법은 성능 저하를 최소화하면서도 경량화된 모..