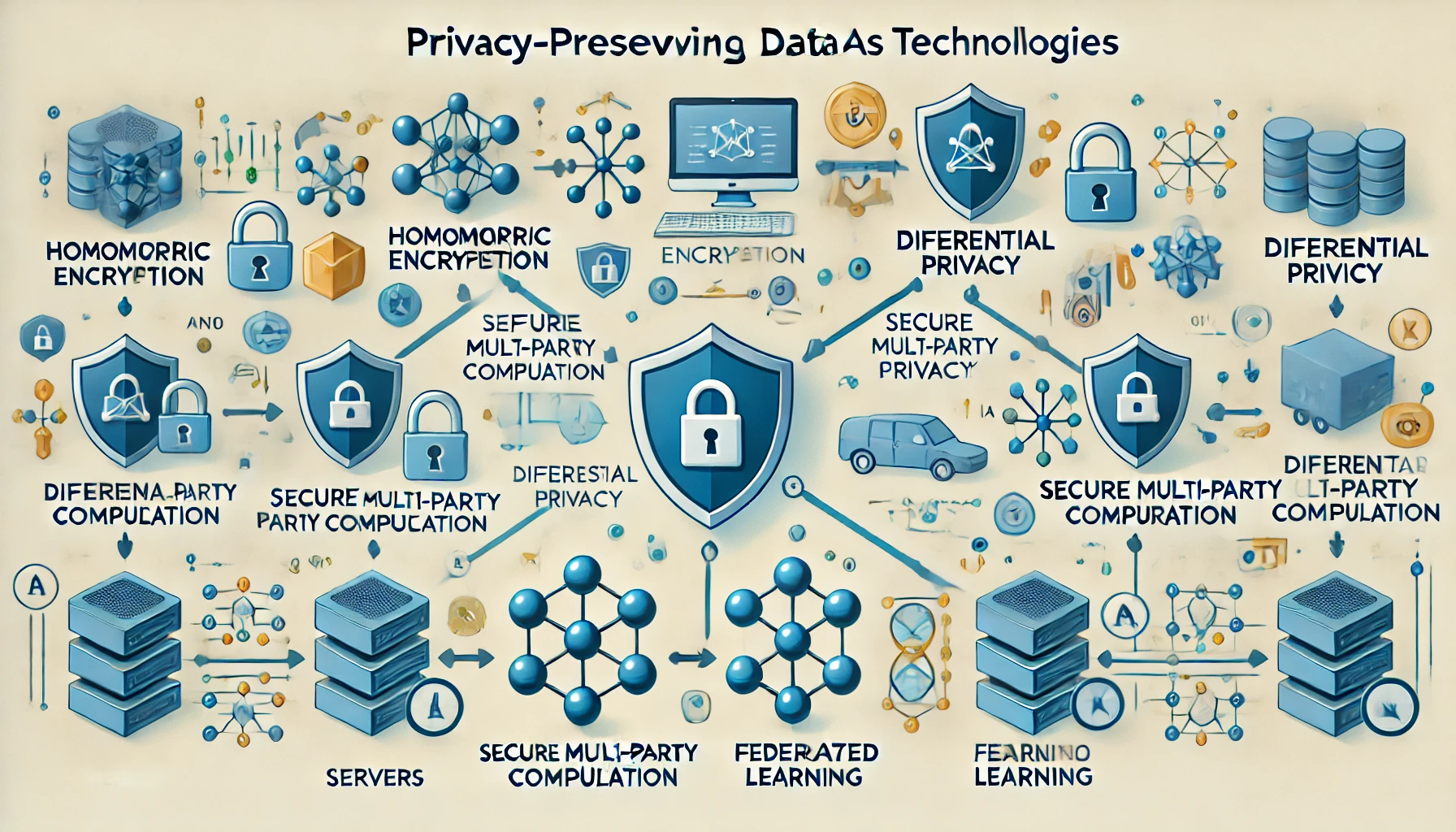

개요PATE(Private Aggregation of Teacher Ensembles)는 Google Brain이 제안한 프라이버시 보호 머신러닝(Privacy-Preserving Machine Learning) 기술로, 민감한 데이터가 포함된 모델 학습 과정에서 차등프라이버시(Differential Privacy)를 보장하면서도 고성능 예측 모델을 만들기 위한 방법론입니다. 여러 개의 개별 모델(Teacher)에서 나온 예측 결과를 프라이버시 보호 집계(Aggregation) 기법으로 결합해 Student 모델을 학습시키는 구조입니다.1. 개념 및 정의항목내용비고정의여러 Teacher 모델이 제공한 예측을 안전하게 집계하여 Student 모델을 학습시키는 프라이버시 보호 학습 구조2017 Google ..