개요

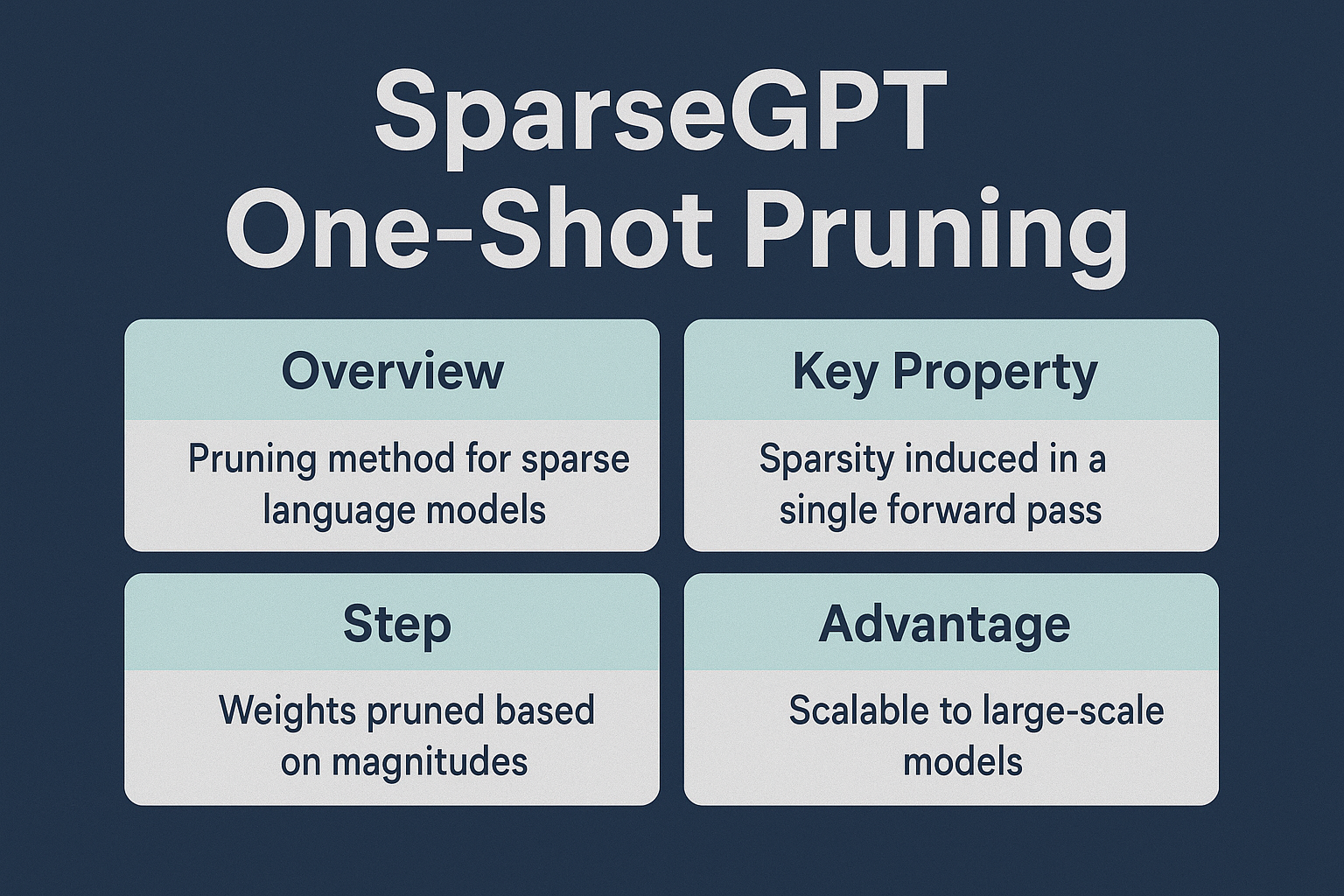

SparseGPT One-Shot Pruning은 사전 학습된 대형 언어 모델(LLM)을 희소화(sparsification)하여 연산량과 메모리 요구량을 줄이기 위한 혁신적인 기법입니다. 이 방법은 단 한 번의 forward pass만으로 전체 모델의 가중치를 효율적으로 제거하는 특징을 가지며, 복잡한 재학습(fine-tuning) 없이도 높은 정확도를 유지합니다.

1. 개념 및 정의

| 항목 | 내용 |

| 정의 | One-shot 방식으로 파라미터를 희소화하는 LLM 전처리 기법 |

| 목적 | 모델 추론 속도 향상 및 메모리 사용량 감소 |

| 방식 | 단일 forward pass 기반 가중치 중요도 평가 후 pruning |

이 방식은 특히 학습 자원이 부족한 환경에서도 기존 GPT 모델을 경량화하여 빠르게 배포할 수 있게 합니다.

2. 특징

| 특징 | 설명 | 비교 |

| One-shot pruning | 재학습 없이 단일 패스로 희소화 | 기존 iterative pruning 대비 10배 이상 빠름 |

| 구조적 희소성 도입 | Layer 단위의 구조적 pruning 가능 | 랜덤 pruning보다 성능 유지율 높음 |

| LLM 특화 설계 | GPT 아키텍처의 특성과 호환 | 일반 모델보다 높은 보존 정확도 |

| 연산 효율 최적화 | Sparse kernel 활용 시 최대 2~4배 속도 향상 | dense 모델 대비 추론비용 절감 |

SparseGPT는 특히 GPT-NeoX, LLaMA, Falcon 등 다양한 오픈소스 LLM에 적용된 사례가 다수 존재합니다.

3. 구성 요소 및 작동 절차

| 단계 | 설명 | 역할 |

| 1. Forward pass | 전체 입력을 모델에 한 번 통과 | 중요도 계산을 위한 활성화 수집 |

| 2. Hessian approximation | 간단한 곱 연산으로 중요도 추정 | pruning 영향 최소화를 위한 기반 정보 생성 |

| 3. Weight magnitude 기준 정렬 | 작은 값 우선 제거 | 손실 최소화 및 sparsity 조절 |

| 4. Pruned Model 생성 | 희소 모델 저장 및 배포 | 연산 최적화 및 모델 크기 감소 |

이러한 절차는 175B 파라미터 모델도 수 분 내 처리 가능하게 하며, 특히 학습 데이터가 공개되지 않아도 사용 가능합니다.

4. 기술 요소

| 기술 요소 | 설명 | 연관 기술 |

| Magnitude-based pruning | 가중치의 절대값 기반 정렬 및 제거 | L0/L1 regularization 기법과 유사 |

| Hessian-aware Pruning | 단순 근사 기반 중요도 계산 | O(n) 계산 복잡도 유지 |

| Block-wise Pruning | 고정된 block 단위로 pruning 적용 | sparse kernel 활용 시 가속 효과 극대화 |

| Transformer-specific Strategy | attention/QKV 구조에 맞춘 제거 방식 | GPT류 모델에 최적화됨 |

SparseGPT는 특히 GPU inference latency 개선을 염두에 둔 실용적인 희소화 전략을 제시합니다.

5. 장점 및 이점

| 장점 | 설명 | 기대 효과 |

| 빠른 처리 시간 | 단일 패스 방식으로 pruning | LLM 튜닝 시간 대폭 단축 |

| 재학습 불필요 | fine-tuning 없이도 사용 가능 | 실시간 경량화 시나리오에 적합 |

| 높은 정확도 유지 | 희소화 후에도 정확도 손실 최소화 | 활용 가능성 확대 |

| 범용성 | 다양한 GPT 아키텍처에 적용 가능 | 연구 및 서비스 모두 활용 가능 |

특히 inference latency 개선 및 edge deployment에 유리합니다.

6. 활용 사례 및 고려사항

| 활용 분야 | 설명 | 고려사항 |

| LLM 서비스 경량화 | 챗봇, 요약기 등 경량 모델 배포 | 희소 커널 지원 여부 확인 필요 |

| 클라우드 비용 최적화 | 연산량 감소로 GPU 시간 단축 | 정확도 검증 필요 |

| 온디바이스 AI | 모바일/임베디드 환경에 적합 | 희소 연산 가속기 하드웨어 필요 |

| MLOps 통합 | 자동화된 pruning pipeline 구현 | pruning ratio 관리 전략 설계 필요 |

도입 시 GPU 커널 최적화와 함께 sparse-aware inference 프레임워크(PyTorch SparseTensor 등) 지원 여부를 확인해야 합니다.

7. 결론

SparseGPT One-Shot Pruning은 대규모 언어 모델을 빠르고 정확하게 희소화할 수 있는 혁신적 기법으로, 최소의 계산으로 최대의 성능을 유지하는 모델 경량화 솔루션입니다. 특히 메모리와 속도 제한이 있는 환경에서 LLM 활용도를 극대화하는 데 적합하며, 앞으로의 모델 경량화 트렌드를 주도할 핵심 기술로 자리잡고 있습니다.

'Topic' 카테고리의 다른 글

| PaLM-E (Pathways Language Model - Embodied) (1) | 2025.05.26 |

|---|---|

| DiT (Diffusion Transformer) (0) | 2025.05.26 |

| Mamba (1) | 2025.05.26 |

| State-Space Model(상태공간 모델) (0) | 2025.05.26 |

| Direct Preference Optimization (DPO) (2) | 2025.05.26 |