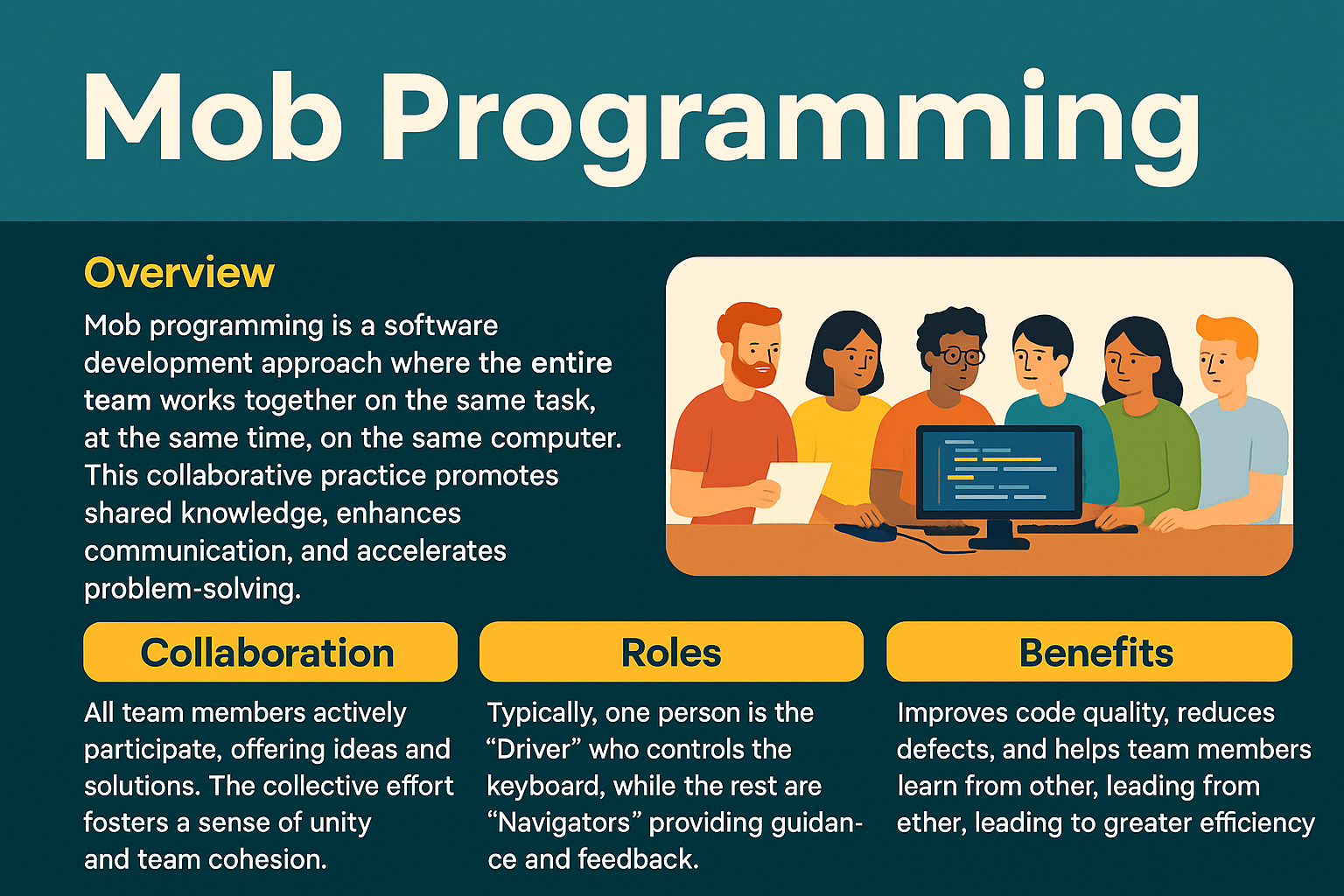

개요Mob Programming은 개발 팀 전체가 한 공간(또는 원격 환경)에서 하나의 컴퓨터로 하나의 작업을 동시에 수행하는 개발 방식입니다. 전통적인 페어 프로그래밍(Pair Programming)을 확장한 형태로, 개발자뿐 아니라 디자이너, 테스터, PO 등 다양한 역할이 한 팀으로 코딩, 리뷰, 테스트, 설계, 문서화를 실시간으로 공동 수행합니다. 이 방식은 코드 품질 향상, 팀 역량 공유, 결함 감소 등의 효과를 통해 집단 지성 기반의 개발 문화를 만들어냅니다.1. 개념 및 정의 항목 설명 정의Mob Programming은 하나의 작업을 위해 팀 전체가 동일한 시점에, 동일한 장소에서 하나의 키보드로 협력 개발하는 방식입니다.핵심 구성Driver(입력 담당자), Navigators(의사결정자들..